Partez à la découverte du fonctionnement de l’algorithme pivot de Google qui a établi un standard dans la conception des moteurs de recherches.

Introduction

Le domaine du SEO rentre dans une nouvelle décennie marquée par la démocratisation de l’Intelligence Artificielle dans les moteurs de recherche. Les internautes sont spectateurs d'une course effrénée où la dilution de l’IA dans les habitudes de recherche pose des interrogations sur l'avenir de l’expertise SEO. Cependant, cet élan n’est pas moins que le résultat d’une suite de bouleversements incluse dans l’ADN du search engine optimization.

Parmi les évolutions qui ont façonné notre compréhension des moteurs de recherche, il existe un témoin qui représente à lui seul les stigmates du progrès. Entre ombre et lumière, retour sur l’algorithme fondateur de Google et du monde SEO : PageRank.

Histoire de Google PageRank

Nous ne présentons plus Google. Moteur de recherche ultra dominant dans le monde (93,1 % de part de marché tout support confondu en 2022, statcounter.com), elle est la plate-forme au centre de l’attention de toute expertise SEO. Chacune de ses mises à jour est scrutée, analysée et décomposée en études comparatives afin d’en mesurer l’impact sur la Search Engine Results Page (SERP).

Même si aujourd'hui, Google fait appel à un vaste éventail d'algorithmes spécialisés pour répondre de manière ciblée à chaque demande, un programme suscite toujours un intérêt particulier. Il s’agit d’une succession de concepts à l’origine même de la création de Google. Celui autour duquel s’est construite l’écrasante notoriété de Google, au point de rendre obsolète dès sa mise en ligne tous les autres moteurs de recherche (Altavista, Excite, Lycos, Wanderer) de l’époque : PageRank.

Mentionnée pour la première fois en 1996 en tant que prototype dans les travaux de Sergey Brin and Lawrence Page (« The Anatomy of a Large-Scale Hypertextual Web Search Engine », stanford.edu), PageRank est la réponse à une problématique notable : « Comment classer de manière efficiente un volume conséquent de résultats potentiels en fonction d’une requête utilisateur ?

À cette époque, les moteurs de recherche les plus connus se basaient exclusivement sur des correspondances exactes de mots clés comme critère de pertinence. Avec l’explosion d’Internet, l’évolution technologique et le volume croissant de pages à indexer, ce mode de classement montrait ses limites.

Cette classification ouvrait inéluctablement la porte à l’élaboration de techniques black hat SEO (ensemble de pratiques abusives destinées à tromper l’algorithme en sa faveur). Le mode de classification basé sur le PageRank a anticipé cette obsolescence pour proposer un fonctionnement alors révolutionnaire pour l’époque.

PageRank se base sur un indice de classification déjà expérimenté depuis 1964 par le scientifique américain Eugene Garfield : le Science Citation Index (SCI). Cette base de données bibliographiques utilisait un modèle de notoriété basée sur la fréquence de citations pour déterminer le classement des documents scientifiques. Ainsi, plus un dossier était cité par d’autres sources, plus importante était sa légitimité à apparaitre dans les résultats de recherche.

Google a repris ce principe pionnier en substituant la notion de « citation » par la notion de « lien entrant ». Sergey Brin and Lawrence Page se sont également inspirés des travaux sur l’« Hyper Search » menés par Massimo Marchiori (« The Quest for Correct Information on the Web : Hyper Search Engines », University of Padova). Par cet autre apport de connaissance, PageRank s’est donné la capacité de distinguer dans son calcul les liens entrants (ou « hyperliens ») des contenus textes, ainsi que de cimenter son interopérabilité avec la fonction de notation sémantique classique.

Google et son programme désormais indissociable PageRank furent introduits en 1998 au grand public. Le moteur de recherche détient les droits du nom mais le brevet de l’algorithme fut déposé et détenu par l’université de Stanford. En échange d’un droit de licence exclusif, Google donna 1,8 millions de ses parts d’actionnariat à l’université, qu’elle revendra en 2005 pour 336 millions de dollars.

À mesure que Google devenait de plus en plus populaire et prenait la tête du marché, de nombreuses modifications ont été apportées afin de mieux répondre aux attentes de recherche de l'utilisateur. Ses itérations sont perçues dans l’algorithme PageRank sous plusieurs modélisations mathématiques successives.

Calcul du PageRank

La compréhension du programme pionnier de Mountain View est déduite par un corpus documentaire composé des publications de l’université de Standford et des brevets déposés dont le contenu est rendu public. De nombreuses études indépendantes se sont par la suite agrégées pour tenter d’en sonder la physiologie.

L’algorithme a pour finalité de simuler le comportement humain (personnifié sous le terme « surfeur ») afin d’y associer une notation réaliste de la notoriété d’une page.

a. Premier concept : le surfeur aléatoire

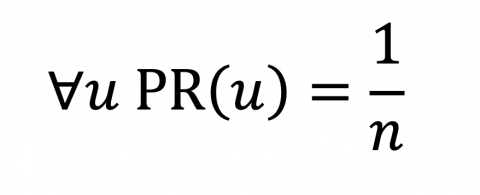

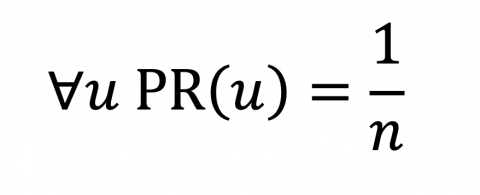

L’information clé à retenir dans la compréhension du système de calcul PageRank est la génération d’une valeur de notoriété individuelle pour chaque page web.

Les pages concernées par ce calcul sont celles qui ont été découvertes par Google et qui ont un contenu canonique et indexable. Cela signifie que les pages invisibles pour le bot de Google (en raison d'une exclusion dans le fichier robots.txt) ou considérées comme non indexables (en raison d'une balise canonique pointant vers une URL différente ou d'une balise meta robots avec "noindex") sont simplement ignorées.

Chaque page indexée possède donc un indice (abrégé « PR » pour PageRank) de notoriété qui lui est associé. Cette notation est calculée par la somme des valeurs des liens entrants pointant vers elle. Cet indice, une fois constitué, est vu comme un « réservoir de PageRank » (1/n) qui sera distribué aux pages ciblées par les liens sortants. Ce paramètre prend également en compte le nombre de pages du même nom de domaine de manière proportionnelle.

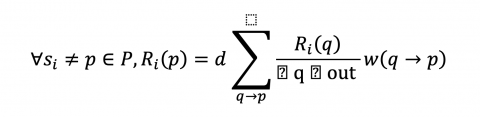

C’est à ce moment que rentre en scène le calcul de probabilité dit du surfeur « aléatoire ». En fonction du nombre de liens présents dans la page source (NL), le PageRank transmis sera divisé équitablement entre ces dernières à hauteur de 85% de sa valeur initiale (c=0,85). Les 15% du PR retirés à cause du facteur d’amortissement est redistribué indépendamment entre toutes les liens.

De ce fait, le concept du « surfeur aléatoire » apporte une première couche avec une distribution équitable et proportionnelle du PR en fonction du nombre de liens sortants de la page source. Cependant, un calcul aussi simple ne peut correspondre à la complexité d’un comportement humain. Ainsi, un second concept intitulé « surfeur raisonnable » est associé.

b. Second concept : le surfeur raisonnable

Déposé en tant que brevet en 2004, cette nouvelle couche de calcul a pour objectif de prédire le taux de clic d’un lien selon son emplacement au sein de la page source. Ainsi, en tentant de deviner la probabilité de conversion d’un lien sortant, l’algorithme va donner un coefficient individuel qui aura une incidence sur la transmission du PR vers la page cible.

Pour ce faire, la page est découpée en plusieurs zones distinctes, octroyant aux liens qu’elles contiennent un poids différent. À titre d’exemple, Google considère le premier lien du contenu <body> comme plus important qu’un lien de bas de page ou du footer. Le paramètre visuel souvent évoqué par les experts SEO est également son emplacement en fonction de la ligne de flottaison.

Par cette logique, le surfeur raisonnable rajoute une épaisseur à l’algorithme. Google s’assure par ce biais que la transmission de notoriété soit inégale en fonction du placement des liens.

Cependant, cette nouvelle justification de calcul n’est toujours pas crédible car elle ne prend pas en considération l’aspect sémantique. C’est pourquoi le programme se donne une troisième couche de calcul avec l’introduction du PageRank thématique.

c. Troisième concept : PageRank thématique

Le rapprochement thématique rentre désormais en compte dans le PageRank. Dans sa formulation globale, elle agit à la même hauteur que le surfeur raisonnable. Elle influe sur la dilution de popularité transmise par chaque lien avec la similarité thématique du corpus de mots employés entre la source et la cible.

L’intérêt de ce critère thématique dans l’algorithme est double :

- Google se dote d’un mode de classification capable de catégoriser de manière automatisée les pages en fonction de cluster thématiques.

- Par corrélation, le moteur de recherche segmente les pages en fonction du thème et permet de couper drastiquement le flux de notoriété d’une page source vers une autre en cas de hors-sujet.

Dorénavant, la plate-forme s’offre d’intéressantes perspectives dans le domaine de la recherche contextuelle en effaçant au passage la problématique des requêtes polysémiques où une requête pouvait avoir une signification différente en fonction de sa thématique. En conséquence, les situations pour lesquelles une thématique sémantique cannibalisait la visibilité d’une autre à cause d’un réservoir PR plus important se sont amoindries.

Avec cette nouvelle modélisation, l’algorithme s’affirme comme le premier asset à avoir subi au cours du temps la doctrine de référencement de Google. D’abord axé sur une approche purement technique basée sur un système de probabilité, PageRank se devait de poursuivre ses évolutions pour correspondre à la tendance « human-centric » de la politique de référencement du moteur de recherche. L’apparition d’un récent brevet Google va cependant rebattre drastiquement les cartes de notre connaissance de PageRank.

d. Mise à jour du concept : PageRank, EEAT et proximité de liens

Introduit le 24 avril 2018 à l’occasion du renouvellement décennal du brevet PageRank (dans sa version originale parue dans les archives universitaires de Stanford), la nouvelle version de l’algorithme (créé par Nissan Hajaj, ingénieur lead à Google) se distingue par un rapprochement avec un autre concept indissociable des Quality Raters : EAT (Expertise, Authoritativeness, Trustworthiness). De cette manière, l’algorithme se donne un sens nouveau et prend en compte la notation de confiance (ou Trustworthiness) attribuée à chaque page source.

Dès lors, la valeur d’un hyperlien est confrontée à des notions de contenus comme l’originalité, l’exactitude des informations, la maîtrise et l’exhaustivité du sujet abordé. Ces nouveaux facteurs amènent irrémédiablement l’algorithme à prendre plus de hauteur vis-à-vis de la page source et de traiter en parallèle le site source comme un indicateur de fiabilité. L’idée des contenus racines (traduit de “seed pages”) prend donc de l’importance.

À ne pas confondre avec la notion de contenus thématiques “Your Money Your Life” (YMYL) qui peuvent influer une décision majeure dans la vie d’un individu en matière économique et sanitaire. L’identification de ces entités se porte également sur le concept de l’EAT, avec une appétence particulière pour les sites traitant de la santé, de l’économie et d’actualités.

Cependant, cette manœuvre semble apporter une contrainte pour le moteur de recherche qui doit tenir à jour un classement de sites “racines” qui serviront de références dans la définition d’une autre métrique : la proximité des pages.

La proximité des pages est une nouvelle métrique qui résulte de la volonté de déterminer l’origine de l’information, et donc en mesurer la fiabilité. Le postulat est qu’un lien direct avec une page “racine” est jugé plus avantageux qu’un lien avec une page citant elle-même une source “racine”. La notion de curation et d’altération de l’information prend donc part au calcul de la transmission de notoriété.

Ce nouveau concept espère amener deux effets notables :

- L’augmentation des propositions de contenus de confiance, proche des sources citées car limités par les itérations et les nuances.

- La diminution des techniques manipulatrices de net linking comme le spam de liens avec la qualité du lien primant désormais sur la quantité.

En conclusion, ce nouveau millésime apporte son lot d’innovations qui peuvent se résumer avec cette nouvelle formule qui prend en compte les poids (w(q → p)) associés aux liens entre les pages.

Bien que l’exhaustivité des informations rapportées dans cet article dépende de l’analyse des informations mises à disposition par Google (description de brevets, documentations techniques, guidelines, etc…), l’influence de PageRank pour chaque requête est à mettre en perspective avec des dizaines d’autres facteurs complémentaires.

Quelques autres algorithmes interopérables avec le PageRank

Comme mentionné dans l’introduction, Google fonctionne grâce à la cohésion d’une myriade d’algorithmes spécialisés. Par ce procédé et la place historiquement centrale qu’occupe PageRank, certains de ces programmes se sont identifiés comme ayant une conception similaire, au point d’en influencer le score PR.

a. Google Panda

Apparue en février 2011, Google Panda fut conçu pour faire face aux divers abus liés aux contenus de faible qualité comme du duplicate content, un volume de contenu insuffisant, des erreurs d’orthographe, des publicités intrusives, du contenu déceptif... À une époque où le concept d’EAT n’était pas défini dans la ligne de conduite de Google, sa mise en place était un précurseur dans la lutte contre les sites internet douteux et son ombre se fait toujours sentir aujourd’hui.

À la différence de son homologue Google Penguin, Panda donne une appréciation nominative à l’ensemble d’un site, ce qui peut altérer à un degré relatif le statut "racine” du contenu.

b. Google Penguin

Ce n’est finalement pas une surprise, l’existence de cet algorithme anti-spam est liée aux divers abus qui ont émaillé l’histoire de PageRank. Google Penguin fut lancé le 24 avril 2012 dans l’objectif de contrecarrer les manipulations de spamdexing, le cloacking, le keyword stuffing, le commerce de liens et autres.

Par le biais de ses différentes versions publiées entre 2012 et 2016, cet algorithme est maintenant capable en temps réel (depuis Google Penguin 4.0 parue le 23 septembre 2016) de rapidement détecter les techniques abusives de linking externe comme les PBN (réseaux de sites web de haute autorité qui sont tous destinés à mieux référencer un site principal cible). L’instantanéité du traitement des liens externes permet également à Google d'adapter ses pénalités et de les retirer de manière prompte sans attendre un nouveau crawl de Google Penguin.

27 ans plus tard, PageRank est-il toujours pertinent ?

Pour répondre à cette question, un petit retour en arrière est nécessaire.

En 2000, Google lança une fonctionnalité éloquente intégrée directement dans la barre de navigation d’Internet Explorer : la « PageRank Toolbar ». Parmi les fonctionnalités à disposition, cet outil accessible à tous donnait une appréciation sous forme de note de la page visitée par le navigateur.

Pour ainsi dire, le public avait désormais un indicateur précis de la notoriété d’une page… donnée par le moteur de recherche lui-même ! Bien que Google précisa qu’il s’agissait d’une valeur indicative à but pédagogique (atteindre la note maximale était simplement contre-productif), il ne fallut pas bien longtemps pour que cet outil devienne une véritable obsession pour la communauté SEO.

La mise en avant visuelle de PageRank a provoqué une attention déraisonnable, loin de ce à quoi Google s’attendait. Ainsi, l’intervention SEO se concentrait essentiellement autour des pratiques de net linking au détriment de la qualité du contenu. Un parallèle peut également être réalisé avec les parutions successives de Google Panda en 2011 et Google Penguin en 2012 pour limiter les pratiques grey et black hats comme le spamdexing, le keyword stuffing, le duplicate content, le cloaking, les content farms, etc...

C’est en 2016 que Google pris la décision de faire disparaitre la PageRank Toolbar. Ce tomber de rideau aussi brutal qu’attendu à cause du délaissement de ses mises à jour depuis 2013 apporta son lot de questionnements sur les priorisations des actions SEO. Dorénavant, la réflexion s’est déplacée sur la qualité du contenu ainsi que sur la pertinence des mots clés. Et c’est à grand renfort de communication par le biais de porte-paroles comme Matt Cutts puis John Mueller que la transformation va s’opérer.

Est-ce pour autant le chant du cygne de l’algorithme PageRank ? La réponse est sans nulle doute non. Car comme décrit dans sa mise à jour de 2018, le programme n’a fait qu’évoluer au point de ne plus promouvoir la même simplicité de calcul qu’à son origine. En effet, PageRank peut à ce jour être définit comme une imbrication d’algorithmes nuançant par les uns les scores obtenus par les autres.

Avec l’implémentation du référentiel Google EEAT (nouvelle version du document de recommandations officielles EAT émis en 2014) sur la fiabilité du contenu, l’impact du net linking ne se mesure plus à la densité technique de liens mais à la pertinence du contenu associé. Les bases de calcul ont donc évolué pour proposer à chaque requête des contenus originaux (first-hand experience) et de confiance correspondant à l’intention de recherche.

Symptomatique de ce changement, de nombreux outils SEO ont banni le terme PageRank pour proposer un système de notation simulant la perception par Google d’un contenu en fonction de ses critères EEAT. Leurs noms ? Le Trust Flow de Majestic, l’Authority Score de Semrush, le Domain Rating de Ahref ou encore le Domain Authority de Moz.

Il est important de préciser qu’avec le secret de glace entourant le comportement de l’algorithme de Google, le score donné par ces dispositifs se base sur des facteurs à l’importance supposée. Ainsi les informations providentielles fournies par le leak de Yandex en janvier 2023, moteur de recherche majeur sur le marché russophone, ont soulevé plus d'interrogations que n'ont donné de réponses.

PageRank n’a donc pas fini de se métamorphoser au gré des besoins de ses surfeurs, des avancées technologiques et des nouveaux algorithmes qui l’ont rejoint depuis la création de Google.

Afin d’étayer cette affirmation, un ingénieur de Google a déclaré publiquement que l’algorithme dans sa version originale n’est plus utilisé depuis 2006 (ycombinator.com). Également signe d’un phœnix loin d’être consumé, John Muller (Search Advocate à Google) a confirmé dans un Q&A de 2019 que PageRank était encore actif au sein de l’écosystème Google. Cependant, ce dernier ne représente plus un facteur de référencement majeur.

Enfin, le 24 septembre de la même année, le brevet de la version primitive de PageRank expire sans tentative de renouvellement.

Quelques conseils pour apprivoiser le PageRank

Après cette accumulation de connaissances, donner de bonnes pratiques universelles semble contre-productif pour ainsi dire impossible. Chaque thématique est unique dans les sujets abordés et Google ne reproduira pas l’erreur de sa « PageRank Toolbar » pour éviter toute déviance. Ainsi, le retour d'expérience associée à l’ancienneté de l’algorithme est l’unique indice de pertinence. Voici quelques points à implémenter dans toute stratégie SEO :

- Texte d’ancrage : proposer un texte personnalisé et en phase avec la thématique de la page cible.

- Mise en valeur du lien basée sur le concept de surfeur raisonnable : Mettre en place des liens à proximité de contenus riches et pertinents. Avec une préférence au-dessus de la ligne de flottaison comme conseillé par certains experts SEO.

- Liens internes : Organiser la structure de votre maillage interne en silos sémantique et optimiser le budget crawl. Ne pas hésiter à supprimer les pages au contenu obsolète pour éviter la dilution inutile du PageRank.

- Niveau de confiance du site source : Créer des liens de qualité en relation avec les sites de confiance YMYL.

- Cluster thématique : Assurez-vous de ne pas faire de hors sujet et de proposer du contenu en lien étroit avec votre sujet de contenu.

À noter que les partages de lien sur les réseaux sociaux ne sont pas pris en compte dans le calcul.

Enfin, le conseil « Roi » est de toujours chercher à créer un contenu original, exhaustif et didactique pour les utilisateurs effectuant une recherche définie.

Conclusion

PageRank est la définition même de Google. C'est la raison de son existence et aussi ce qui a rendu le moteur de recherche si unique. Mais s’en tenir à cette définition de surface pour tirer des conclusions sur le fonctionnement de Google relève du déraisonnable.

Depuis bientôt trois décennies, Google a su développer un microcosme de facteurs de référencement supplémentaires pour épauler la tâche de PageRank. Au fil du temps, PageRank a perdu de son importance initiale. Ainsi,de nouveaux critères liés directement au contenu sont à l’œuvre. La qualité offerte à l'utilisateur est désormais intrinsèquement liée à la pertinence du moteur de recherche.

L’avènement prochain de l’Intelligence Artificielle offrira de nouvelles perspectives intéressantes pour fournir aux utilisateurs de Google une expérience à la fois unique et satisfaisante. À l’image de son premier principe fondateur : “Focus on the user, the rest will follow”.

By Stéphane Auroux, Consultant SEO

We Create Continuous Relationship Experiences !